Meta, Nisan 2024 tarihinde yeni nesil teknolojiye sahip Llama 3 adlı açık kaynaklı büyük dil modelleri (LLM) duyurdu. İlk iki model olan Llama 3 8B ve Llama 3 70B kendi boyutlarındaki LLM’ler için yeni ölçütler belirledi ve sadece 3 ay içinde diğer birçok LLM onların performansını aştı.

Meta, en büyük Llama 3 modelinin 400 milyarın üzerinde parametreye sahip olacağını ve halen eğitim aşamasında olduğunu zaten açıklamıştı. Şimdi ise LocalLLaMA alt dizini, yakında çıkacak olan Llama 3.1 8B, 70B ve 405B modellerinin erken kriterlerini sızdırdı. Sızan veriler, Meta Llama 3.1 405B’nin birçok önemli yapay zeka testinde mevcut lider OpenAI’ın GPT-4o’sundan daha iyi performans gösterebileceğini gösteriyor. Bu, açık kaynak yapay zeka topluluğu için önemli bir kilometre taşı olarak düşünülüyor. Ayrıca bu, ilk kez bir açık kaynak modelinin mevcut son teknolojiye sahip kapalı kaynak LLM modelini yenebileceğine işaret ediyor.

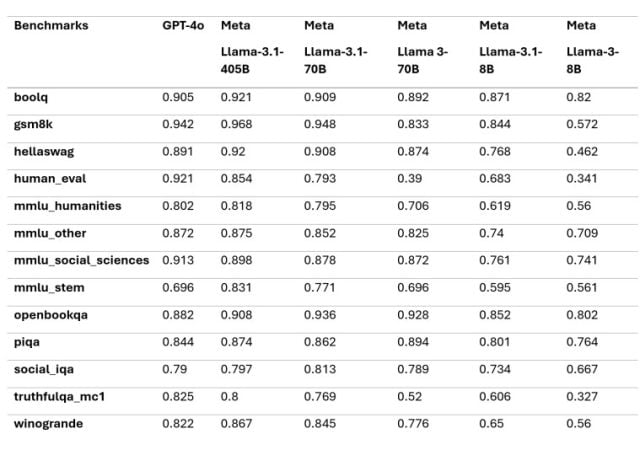

Karşılaştırmalarda gözüktüğü gibi Meta Llama 3.1, aralarında GSM8K, Hellaswag, boolq, MMLU-beşeri bilimler, MMLU-diğer, MMLU-stem ve winograd’ın da bulunduğu çeşitli testlerde GPT-4’ten daha iyi performans gösteriyor. Ancak HumanEval ve MMLU-sosyal bilimlerde geride kalıyor.

Bu sayıların Llama 3.1’in temel modellerinden olduğunu unutmamak gerekiyor. Modelin potansiyelini tam olarak açığa çıkarmak için talimat ayarlaması da önemli. Bu sonuçların çoğu, Llama 3.1 modellerinin Instruct sürümlerinin piyasaya sürülmesiyle iyileşebilir.

OpenAI’ın yakında çıkacak olan GPT-5’i, beklenen gelişmiş muhakeme yetenekleriyle, Llama 3.1’in LLM alanındaki potansiyel liderliğine meydan okuyabilirken Llama 3.1’in GPT-4o’ya karşı güçlü performansı hala açık kaynaklı yapay zeka gelişiminin gücünü ve potansiyelini vurguluyor.